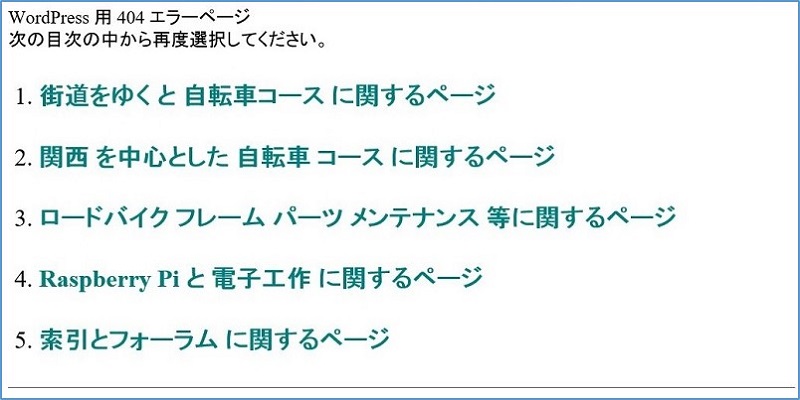

Webサーバー サイトの管理

Search Console

URLエラーを無くす robots.txt の作り方

Search Console

URLエラーを無くす robots.txt の作り方

robots.txt は、GoogleやYahoo!といった検索エンジンが、サイトの情報を取得(クロール)するプログラム(クローラー)を制御するためのテキストファイルで、特定のファイルやディレクトリをクロール禁止に指定することで、これらの関連ページや画像などを、検索エンジンにインデックスさせないようにすることができる。

スポンサー リンク

robots.txtは、ただのテキストファイルなので、メモ帳で十分

robots.txt の作成・編集は、テキストエディターでよい。

最上位のディレクトリに、robots.txt という名前で設置

サイトのルートディレクトリーに、FTPでアップロードする。

最近の検索エンジンは、ロボットでサイトを自動的に解析しており、リンクを辿って各ページを巡回しているように思われる。このロジックがどうなっているか知る由もないが、ページ内に設定した内部リンクが多々あると、ディレクトリーを遷移しながら該当のURLを探すことになり、『URL エラー』のほとんどが、あるはずもないディレクトリーをクロールした結果のように思われる。

http://arakan60.mydns.jp/05forum/03bike/01kaidou/・・・http://arakan60.mydns.jp/04kousaku/04kousaku/03bike/・・・http://arakan60.mydns.jp/04kousaku/01kaidou/03bike/・・・

そこで、上記のようなあるはずもないディレクトリーをブロックすることで、『URL エラー』を無くすることが出来た。

HTMLで作成した PCサイトの robots.txt 例。

ブロックするディレクトリーを記述している。

User-Agent:*

Disallow: /05forum/04kousaku/

Disallow: /05forum/03bike/

Disallow: /05forum/02jiko-su/

Disallow: /05forum/01kaidou/

Disallow: /05forum/img05/

~ 省略 ~

Sitemap: http://arakan60.mydns.jp/sitemap.xml

WordPress サイトの robots.txt 例。

ブロックするディレクトリーを記述している。

User-Agent:*

Disallow: /wp-admin/

Disallow: /wp-includes/

Allow: /wp-includes/js/

Disallow: /02jiko-su/27oosaka/img27osk/2711mkcycleline/

Disallow: /02jiko-su/27oosaka/img27osk/green/

~ 省略 ~

Sitemap: https://arakan60.com/wpsitemap.xml

robots.txt の記述要領。

記述は簡単で、下記以外にもパターンマッチ指定なども出来る。

User-agent: * ← # 全てのクローラーを対象

User-agent: Googlebot ← # Google

User-agent: Googlebot-Image ← # Google画像検索クローラー

User-agent: Googlebot ← # Google

User-agent: Googlebot-Image ← # Google画像検索クローラー

Disallow: /xxxxx ← クロールの禁止

Allow: /yyyyy ← クロールの許可

Allow: /yyyyy ← クロールの許可

# パスはスラッシュ文字(/)から指定

Disallow: /xxxxx/aaaaa.html ← 特定のページ

Disallow: /xxxxx/ ← 特定のディレクトリ

Sitemap: https://arakan60.com/wpsitemap.xml ← サイトマップの指定

Disallow: /xxxxx/ ← 特定のディレクトリ

Sitemap: https://arakan60.com/wpsitemap.xml ← サイトマップの指定

robots.txt ファイルに「サイトマップへのパス」を指定して置くと便利。

参考:

以上。

(2016.11.16)

スポンサー リンク